tg-me.com/pytorch_howsam/640

Last Update:

آقای Sebastian Raschka بلاگ پستی درباره Reasoning در LLM-ها نوشته. در ادامه خلاصهای از این پست رو آوردم. هرچند پیشنهاد میشه که پست کامل خونده بشه. لینک

قبل از DeepSeek-R1، تقویت توانایی استدلال (Reasoning) در مدلها معمولا مبتنی بر فاینتیون باناظر و یادگیری تقویتی (SFT+RL) بود. به این شکل که بعد از مرحله Pretrain، مدلها ابتدا با یادگیری باناظر و سپس با یادگیری تقویتی آموزش داده میشدن تا قابلیت استدلال بهبود پیدا کند.

با اومدن DeepSeek-R1، روشهای کارآمد دیگهای هم برای افزایش توانایی استدلال در مدلها معرفی شد:

* روش فقط یادگیری تقویتی (Pure RL)

* روش فقط یادگیری باناظر (Pure SFT)

در روش Pure RL، مدل DeepSeek-R1-Zero توسعه داده شد. در این روش، به جای استفاده از فیدبک انسانی، دو Reward به نامهای Accuracy و Format تعریف شدن. برای مثال، در پرامپتها و سوالهای کدنویسی، Accuracy Reward بر اساس تستکیسها و کامپایلر LeetCode تعیین میشه. یعنی مدل کد تولید میکنه، کامپایلر بررسی کرده و بر اساس صحت خروجی، به مدل فیدبک میده.

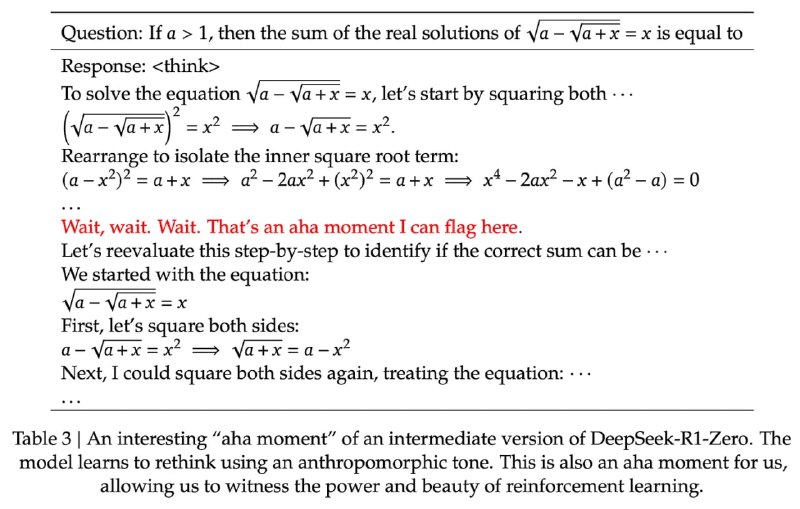

این روش Pure RL باعث شد که مدل بدون نیاز به فیدبک انسانی توانایی استدلالش ارتقا پیدا کنه؛ یک دستاورد کلیدی که احتمالا در ماههای آینده بیشتر در موردش خواهیم شنید. تصویر بالا نشون میده DeepSeek-R1-Zero که فقط با RL آموزش دیده، چگونه یک مسئله ریاضی رو حل میکنه.

روش دوم، فقط یادگیری باناظر (SFT) هست. دیپسیک یک سری مدل کوچکتر بر پایه Llama 3 و Qwen 2.5 رو با SFT آموزش داد و جالب اینکه حتی این مدلها هم تنها با SFT قابلیت استدلال پیدا کردند.

البته، وقتی مدلهای کوچک رو با روش Pure RL آموزش دادن، عملکرد چندان جالبی نداشتن. این نشون میده که مدلهای بزرگتر (مثل DeepSeek-V3) میتونن با Pure RL قابلیت استدلال پیدا کنند، در حالی که مدلهای کوچکتر بیشتر با Pure SFT به این توانایی میرسن.